L’intelligenza artificiale (AI) e le tecnologie digitali sono sempre più presenti nella nostra società, con implicazioni profonde sulla nostra vita quotidiana. L’AI promette di portare benefici in termini di automazione, efficienza e qualità delle esperienze utente. Ma quali sono i rischi per la nostra privacy in un mondo in cui l’intelligenza artificiale ricopre un ruolo sempre più importante?

E ancora: possiamo conciliare il potenziale della tecnologia con il nostro diritto fondamentale alla protezione dei dati personali?

Per cercare di trovare una risposta a queste domande abbiamo chiesto a Diego Maranini, Consulente applicativo, UTOPIA, Dilaxia. Proviamo quindi ad analizzare il rapporto complesso tra privacy e intelligenza artificiale, cercando di capire le sfide e le opportunità che si presentano in un contesto in cui la tecnologia e la sfera personale si intersecano.

Non esiste una sola intelligenza artificiale

L’intelligenza artificiale si può classificare in diverse categorie, a seconda delle caratteristiche e delle capacità dei sistemi. L’intelligenza artificiale a capacità ristretta (ANI) è il livello più basico dell’AI, che può rispondere a domande specifiche o eseguire compiti semplici. Un esempio? Pensiamo ad Alexa, l’assistente vocale di casa Amazon.

All’altro estremo, abbiamo l’intelligenza artificiale generale (AGI), che si basa su framework che emulano le teorie della mente, e si avvicina alle capacità umane. Un passo ulteriore è l’intelligenza artificiale super intelligente (ASI), che supera il livello di intelligenza umana e può arrivare a essere cosciente di sé. Niente paura, non siamo ancora a livelli di Blade Runner.

Ma classificazioni a parte, la domanda da porsi è: cosa rende così popolari modelli di linguaggio come ChatGPT? Una delle risposte risiede sicuramente nell’uso del linguaggio. Del resto attraverso il linguaggio, noi umani, creiamo il mondo, costruiamo le società e tessiamo relazioni. ChatGPT usa oltre un trilione di token linguistici per il suo allenamento, e comunica con gli esseri umani, avvicinandosi a loro come nessuna tecnologia prima. Il modello di Open Ai usa la relazione statistica tra le parole per produrre testo coerente e comprensibile. Però, le parole scelte per la prossimità statistica non sempre corrispondono a situazioni reali, creando quello che gli scienziati dei dati chiamano il “problema della messa a terra”.

BIAS, rischi per la privacy e responsabilità dell’intelligenza artificiale

Un aspetto essenziale da considerare nell’AI è il rischio di BIAS, cioè di pregiudizi. Un campione di dati incompleto o sbagliato, usato per allenare il sistema, possono portare a una rappresentazione falsata della realtà. Anche i pregiudizi umani possono influenzare l’allenamento dell’AI, che può così restituire risposte rappresentanti pregiudizi di carattere discriminatorio o razziale. Del resto la macchina apprende dall’uomo. Riconoscere e ridurre questi BIAS è essenziale per sviluppare sistemi intelligenti giusti, inclusivi e rispettosi dei diritti umani.

Naviga online con NordVPN – Fino a 65% di sconto + 3 mesi EXTRA + 1 buono Regalo Amazon

Non dimentichiamo poi che l’uso dell’Intelligenza Artificiale può avere effetti emotivi importanti sugli esseri umani. Spesso le persone attribuiscono qualità umane come emozioni e comprensione ai modelli di intelligenza artificiale, pensando che siano oracoli affidabili capaci di prendere decisioni (effetto ELIZA). Questo può essere ingannevole e anche pericoloso, soprattutto in caso di persone fragili.

Veniamo ora alle note dolenti: la privacy!

Intelligenza artificiale e privacy: come mitigare i rischi?

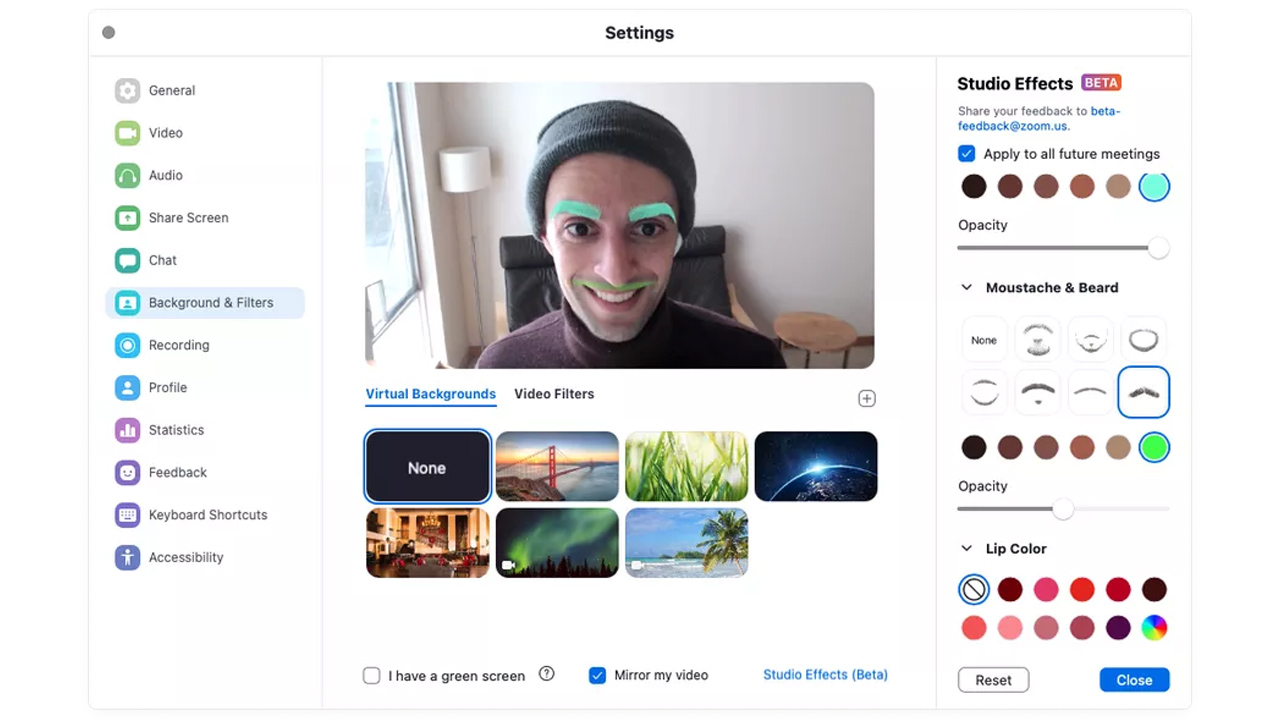

L’AI implica spesso il trattamento di dati personali, cioè di informazioni che possono identificare o rendere identificabili delle persone fisiche. Questo comporta delle implicazioni legali e normative che devono essere rispettate per garantire la protezione dei diritti e delle libertà delle persone interessate. Le applicazioni di intelligenza artificiale possono infatti modificare le finalità per cui i dati sono stati raccolti o trattati, richiedendo una revisione delle autorizzazioni e dei consensi ottenuti. I principi di necessità e limitazione sono essenziali per assicurare che i dati siano utilizzati solo per scopi legittimi e necessari, e non per altri fini incompatibili o illegittimi. Inoltre, è importante definire chiaramente i ruoli e le responsabilità degli attori coinvolti nel processo decisionale automatizzato, per garantire la trasparenza e la rendicontabilità delle decisioni prese dall’AI.

Il Regolamento Generale sulla Protezione dei Dati (GDPR) è il principale riferimento normativo a livello europeo per la tutela dei dati personali. L’articolo 22 del GDPR stabilisce le condizioni per il processo decisionale automatizzato basato sui dati personali, mentre il Considerando 71 fornisce delle linee guida per salvaguardare i diritti e gli interessi delle persone interessate. In Italia, il Decreto Trasparenza introduce ulteriori garanzie per i lavoratori. Quest’ultimo impone al datore di lavoro di analizzare continuamente i rischi e gli impatti delle decisioni automatizzate sui dipendenti, di informarli sui sistemi di intelligenza artificiale utilizzati in azienda e di spiegare loro come sono stati progettati.

L’articolo 6 del GDPR, invece, indica le basi giuridiche che consentono a un’organizzazione di trattare dati personali. Questo articolo è anche il principale riferimento per la finalità di training degli algoritmi, in quanto fornisce un quadro per determinare se il trattamento dei dati personali è lecito. Per gli utenti, si richiede il consenso informato con il diritto di revocarlo in qualsiasi momento, insieme alla fornitura di strumenti per la rettifica dei dati e, qualora non sia possibile, per la cancellazione degli stessi.

Adottare un approccio ibrido

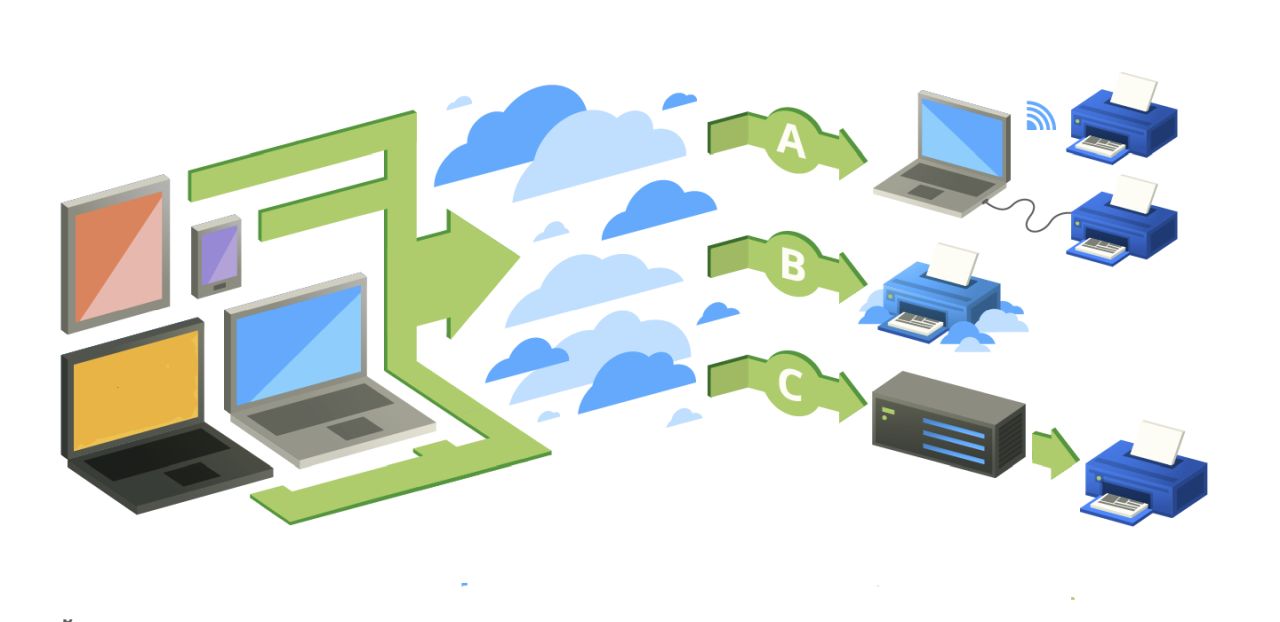

Quando una società decide di integrare grandi modelli di linguaggio all’interno di un proprio progetto, è sempre consigliato un approccio ibrido. Questo permette di combinare i dati del proprio dominio con il modello di linguaggio generale, creando vocabolari e tassonomie specifici che andranno aggiunti al modello di linguaggio originale.

In questo modo, l’output sarà un sistema in grado di sfruttare a pieno le potenzialità del modello di linguaggio generale, ma adattato ai dati del proprio dominio e alle proprie regole.

Inoltre, fin dalla progettazione del sistema è importante privilegiare la cosiddetta intelligenza spiegabile, ovvero “simbolica”. Questa si basa su regole, vocabolari, tassonomie e grafici della conoscenza che rendono possibile spiegare i casi d’uso e le decisioni del sistema e le ragioni dietro di esse. L’intelligenza spiegabile (XAI) supera i limiti dell’intelligenza non spiegabile, la cosiddetta AI “Black box” in cui convergono dati e algoritmi per la creazione di un modello capace di apprendere e decidere in autonomia, con tutti i rischi che questo approccio comporta. Al contrario della AI “Black box”, l’intelligenza “simbolica” rappresenta un mezzo idoneo a garantire la trasparenza e la responsabilità dell’AI.

“In un mondo in cui intelligenza artificiale e privacy si incontrano, il futuro sembra promettente ma complesso”, afferma Diego Maranini. “Mentre l’AI offre automazione, efficienza e miglioramento delle esperienze utente, dobbiamo anche considerare fino a che punto la nostra privacy potrebbe essere compromessa. È essenziale trovare un equilibrio tra il potenziale della tecnologia e il diritto fondamentale alla riservatezza. Il progresso nell’IA richiede una governance umana responsabile, che riconosca i pregiudizi e i rischi associati, mitigandoli attivamente”.

Rimani aggiornato seguendoci su Google News!

Da non perdere questa settimana su Techbusiness

🎵 Synology al Nameless Festival

🧑💻 La rivoluzione dello sviluppo software operata dall'Intelligenza Artificiale

🫵 Le imprese e la trasformazione digitale: il punto della situazione

🚙 Il futuro dell'automotive nel 2025; auto sempre più smart e connesse

📰 Ma lo sai che abbiamo un sacco di newsletter?

📺 Trovi Fjona anche su RAI Play con Touch - Impronta digitale!

🎧 Ascolta il nostro imperdibile podcast Le vie del Tech

💸E trovi un po' di offerte interessanti su Telegram!