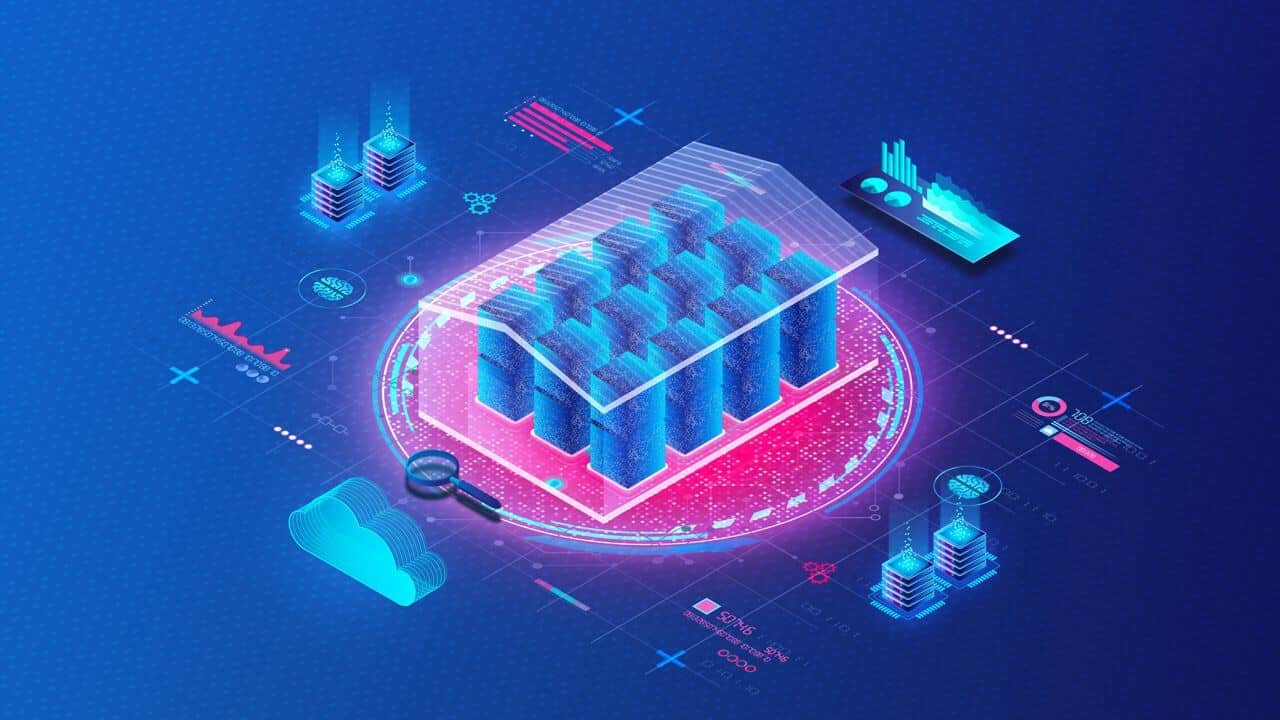

Durante la mia partecipazione a WPC 2023 a Milano, ho avuto l’opportunità di immergermi in sessioni e presentazioni coinvolgenti condotte da esperti del settore IT. Tra i momenti salienti di WPC 2023, l’intervento di Franco Perduca si è distinto per la sua illuminante analisi delle dinamiche legate all’archiviazione e alla gestione dei dati, focalizzandosi in particolare sul confronto tra DataLakehouse e DataWarehouse.

WPC 2023 rappresenta un punto di riferimento formativo nel mondo dell’IT, consolidandosi come la conferenza più importante in Italia per le tecnologie di Microsoft. Nel contesto di questa eccezionale piattaforma, Franco Perduca ha fornito un approfondimento prezioso sulle sfide e le opportunità offerte dalle nuove frontiere dell’archiviazione dati.

DataWarehouse e DataLakehouse a WPC 2023

Il DataLakehouse è un’architettura per la gestione dei dati e che unisce la flessibilità dei DataLake alle funzionalità di gestione dei dati di un DataWarehouse. Trattandosi dell’unione di due mondi distinti, troviamo alcun vantaggi tra cui: il basso costo e la flessibilità del sistema. Purtroppo però troviamo dei limiti, uno tra questi è la scalabilità. Infatti il sistema è scalabile, ma richiede un enorme costo per effettuare questa operazione rendendola di fatto un’operazione difficilmente realizzabile. Un altro limite importante è la gestione dei dati limitata a quelli strutturati, quindi non saranno supportati i dati in streaming.

Il DataLake

Facendo un passo indietro, vediamo che cos’è un DataLake. Si tratta di un sistema di storage, come se fosse un “grosso disco” che contiene una grande quantità di dati in un formato nativo e grezzo. Sfruttando l’archiviazione di oggetti poco costosa e i formati aperti, i DataLake consentono a molte applicazioni di sfruttare i dati.

Come proteggere i tuoi dati? Scopri Bitdefender qui, Leader mondiale nella sicurezza informatica!

Il DataWarehouse

Ora che sappiamo che cos’è un DataLake, passiamo al concetto di DataWarehouse. Si tratta quindi di un sistema di data management progettato per abilitare e supportare le attività di business intelligence (BI), in particolare gli analytics. I DataWarehouse servono esclusivamente a eseguire query e analisi e spesso contengono grandi quantità di dati storici. I dati all’interno di un DataWarehouse sono generalmente derivati da una vasta gamma di origini come i file di registro dell’applicazione e le applicazioni di transazione.

I DataLakehouse introducono un nuovo concetto di sistema aperto. L’obiettivo è implementare strutture e funzionalità per la gestione dei dati, simili a quelle di un DataWarehouse. Questo direttamente su un sistema di stoccaggio dei dati analogo a quello dei DataLake. Fondendo queste due tecnologie in un unico sistema, i team di gestione dei dati possono agire più velocemente. Possono utilizzare i dati senza bisogno di accedere a diversi sistemi. Inoltre, i DataLakehouse fanno sì che i team abbiano sempre a disposizione i dati più completi e aggiornati per progetti di data science, machine learning e business analytics.

Come otteniamo un DataLakehouse?

Alla base di questa innovativa soluzione si cela un’architettura open source basata su Spark, un framework di elaborazione parallela ampiamente utilizzato per ottimizzare la manipolazione dei dati. Questo framework include librerie integrate per la gestione di algoritmi di Machine Learning e l’interfacciamento tramite API. A completare questa struttura, Delta Lake, un framework open source dedicato allo storage, viene sovrapposto al framework di Spark, apportando miglioramenti significativi in termini di affidabilità, sicurezza e prestazioni sui DataLake preesistenti. Da notare che Delta Lake introduce anche un sistema di versioning dei dati, consentendo la creazione di una sorta di archivio storico delle informazioni.

Delta Lake e il suo funzionamento

Il formato di storage adottato è Parquet, un tipo di file open source di natura “colonnare“, caratterizzato da una compressione dati notevole. Ogni file Parquet include un header (intestazione) che fornisce una panoramica del contenuto, facilitando la comprensione dei dati in esso racchiusi. Durante la dimostrazione durante la conferenza, Franco Perduca ha illustrato a WPC 2023 come l’utilizzo del formato Parquet abbia permesso di ridurre le dimensioni di un dato da 717GB in formato SQL a soli 68GB, sottolineando l’importanza del risparmio di memoria, soprattutto in contesti di DataLakehouse e DataWarehouse.

Delta Lake, all’interno del suo robusto framework, offre la gestione avanzata delle transazioni, composta principalmente da due elementi chiave: la Delta Table e il Transaction Log. Ad ogni transazione viene associato un file Parquet, affiancato da un file JSON. Questo processo introduce il concetto di “time travel“, creando una sorta di cronologia del dato che consente il recupero di versioni precedenti.

Le possibilità di ottimizzazione sono diverse, con un focus particolare sulle partizioni che diventano efficaci solo con almeno 1GB di dati. Al contrario, il “Z ordering” si rivela un’ottima strategia per organizzare i dati correlati in prossimità l’uno dell’altro, migliorando sensibilmente le prestazioni di lettura.

Il concetto di One Lake su Microsoft Fabric

Nel contesto di Fabric, il paradigma attuale è “One Lake“, indicando la presenza di un unico sistema per la gestione dei dati, una sorta di “One Drive” dedicato alle informazioni. Gli aggiornamenti futuri di Fabric prevedono un sistema migliorato per il mirroring.

Un aspetto distintivo è il formato dati unificato basato su SQL. L’utilizzo dell’ERP gateway consente l’automazione della creazione e gestione del DataLake su Microsoft Fabric.

All’interno del sistema, troveremo tre tipi di file distinti:

- Semantic Model: Rappresemta il vecchio dataset, un modello semantico del dato.

- File SQL endpoint: Contiene il dato nel formato SQL.

- File Parquet: Esprime il dato in formato Parquet, caratterizzato da una struttura “colonnare” che favorisce una compressione efficiente.

WPC 2023 ha rivelato una prospettiva affascinante sul futuro della gestione dati, evidenziando come architetture come Datalakehouse e DataWarehouse possano convergere e interagire in modo sinergico. Microsoft Fabric emerge come l’emblema di questa integrazione, offrendo un ambiente coeso per sfruttare appieno le potenzialità dei dati in un mondo sempre più orientato all’efficienza e alla versatilità.

Attraverso le dinamiche di archiviazione dati, guidati dalle parole di Franco Perduca e illuminati dalle soluzioni di Microsoft Fabric, rivela un futuro in cui l’integrazione intelligente diventa la chiave per sbloccare il massimo valore dai dati aziendali. In questo scenario, la convergenza di Datalakehouse e DataWarehouse su piattaforme come Fabric rappresenta una scommessa vincente per le imprese desiderose di navigare con successo nell’era dei dati.

- Pradeep Menon (Autore)

Rimani aggiornato seguendoci su Google News!

Da non perdere questa settimana su Techbusiness

📈 SAP NOW 2024 l'intelligenza artificiale per il business conquista Milano💸 Come calcolare il ritorno sugli investimenti nell’Intelligenza Artificiale

👨⚖️ Direttiva NIS2 e cybersecurity nelle PMI italiane obblighi e opportunità

🔫 Metà degli attacchi informatici in Italia prende di mira le supply chain

📰 Ma lo sai che abbiamo un sacco di newsletter?

📺 Trovi Fjona anche su RAI Play con Touch - Impronta digitale!

🎧 Ascolta il nostro imperdibile podcast Le vie del Tech

💸E trovi un po' di offerte interessanti su Telegram!