Per molti siti web, il web scraping è un problema importante in questa epoca di rivoluzione tecnologica dove l’AI impara su numerose quantità di dati, a volte senza permesso alcuno. Con AI Audit, Cloudflare promette di risolvere la piaga di questi bot di web scraping, come scritto nell’articolo di Matthew S. Smith sull’IEEE.

Questo tool, che è stato lanciato in beta il 23 Settembre ed è disponibile a tutti i clienti di Cloudflare, darà agli amministratori dei siti nuovi modi per vedere le attività dei bot basati sull’AI che tentano di estrapolare dati dai siti web.

AI Audit, lo strumento contro i bot di web scraping

Sicuramente l’Intelligenza Artificiale è uno strumento molto potente e molto utile al giorno d’oggi. E l’obiettivo di Cloudflare, come dichiarato da Sam Rhea, Vice Presidente delle tecnologie emergenti per Cloudflare, è quello di rendere Internet un posto migliore, dove ci sono ottimi contenuti e grandi comunità. Purtroppo, l’AI non è sempre usata a fin di bene, perché, sostiene ancora Sam Rhea: “Ma una cosa che ci rende nervosi è che alcuni casi d’uso dell’intelligenza artificiale lo mettono potenzialmente a rischio.”

AI Audit, una misura di protezione contro il traffico indesiderato dai bot

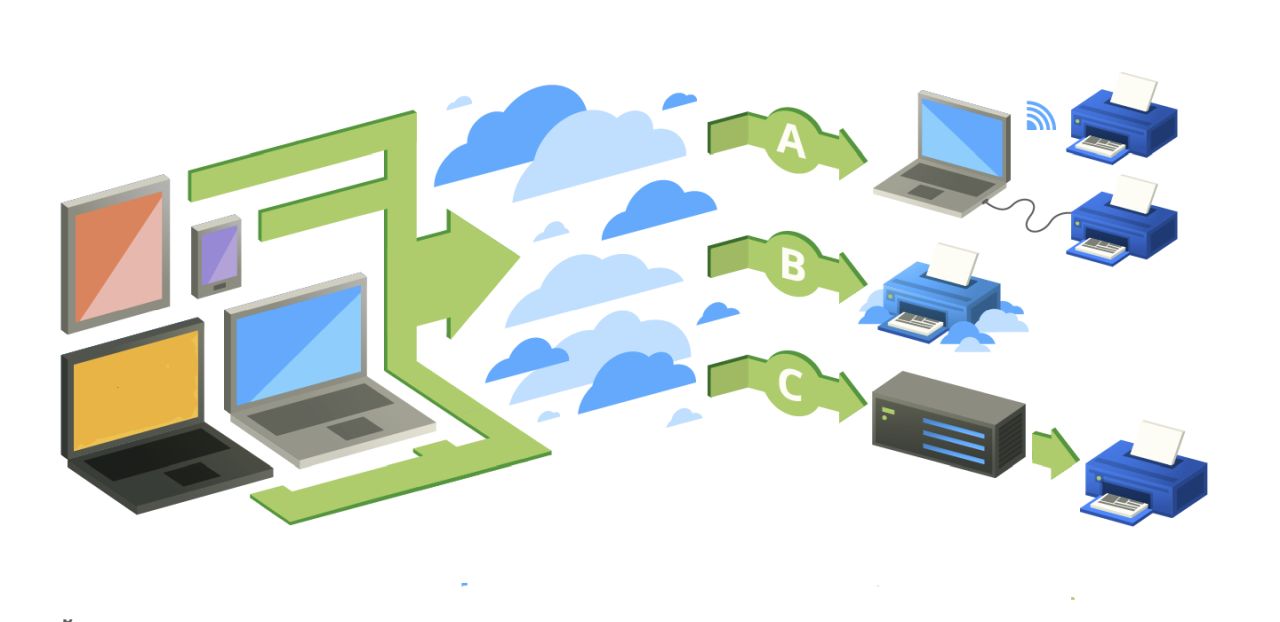

Per controllare meglio il web scraping delle proprie pagine e cosa possono fare i bot, gli amministratori dei siti generalmente usano il file di testo robots.txt. Purtroppo ciò spesso non è esente da falle, perché i bot possono semplicemente ignorare queste istruzioni.

Con AI Audit di Cloudflare però le cose cambiano in meglio. Non più basato su robots.txt, il servizio di protezione diventa Web Application Firewall, un servizio in grado di identificare in automatico le fonti del traffico web. Già usato per contrastare attacchi DDoS, il Web Application Firewall è in grado di contrastare anche questi bot usati dalle compagnie come OpenAI.

Spesso i siti grandi non soffrono però di questi “attacchi” dei bot di web scraping, perché hanno l’infrastruttura adeguata per gestire questo volume di traffico. Per esempio, i siti di Sourceforge e Slashdot hanno traffico da decine di milioni di bot scraper ogni mese, ma la loro infrastruttura regge molto bene.

I siti più piccoli purtroppo questi “attacchi” li soffrono. È il caso di BingeClock, un sito per tenere traccia degli episodi visti di una serie TV, che ha dovuto aggiungere delle risorse server per gestire questo traffico. Billy Gardner McIntyre, sviluppatore freelance che gestisce il sito in autonomia, per tutta l’estate ha dovuto aggiungere sempre nuove istanze per l’API del sito, poiché era diventato praticamente inutilizzabile per i propri utenti. AI Audit ha permesso a McIntyre di alleviare questo traffico web, e lo sviluppatore ha notato un grande abbassamento del traffico.

I bot di web scraping possono essere fermati davvero?

AI Audit ha come principale funzione quella di bloccare i bot di web scraping, ma l’obiettivo di Cloudflare è anche più ambizioso. L’azienda infatti spera che in futuro AI Audit possa dare un compenso a tutti gli amministratori e possessori di siti web ogni volta che i contenuti del loro sito vengono sottoposti a queste pratiche scorrette.

Nonostante sia un obiettivo ambizioso, molti rimangono scettici sul compenso monetario, tra cui lo stesso McIntyre, che ha dichiarato: “Qualunque sia il programma di pagamento, immagino che non saranno molti soldi. Semplicemente non vedo come potrebbero monetizzarlo. Mi piacerebbe essere smentito.” Al momento, Cloudflare non ha rilasciato dichiarazioni in merito allo sviluppo futuro di questo software di monetizzazione.

Molti sono dubbiosi anche sull’uso di AI Audit, perché potrebbe causare l’erosione dell’Internet libero: solamente chi paga per accedere ai dati di un sito web potrebbe farne data scraping, anche se molte compagnie non li utilizzerebbero per allenare un’AI generativa, come nel caso di Wayback Machine di Common Crawl.

Sam Rhea ha dichiarato che non c’è l’intenzione di utilizzare AI Audit come strumento per controllare o monitorare il traffico web. “È una domanda interessante, ma non la stiamo affatto prendendo in considerazione […] siamo molto concentrati solamente sulle scansioni provenienti da bot.”

- Mitchell, Ryan (Autore)

Rimani aggiornato seguendoci su Google News!

Da non perdere questa settimana su Techbusiness

🥷 La situazione della cyberwarfare in Italia e nel mondo

🏢 Aruba consolida la sua presenza sul territorio con un nuovo data center a Roma

🧠 Intelligenza artificiale e non: generare un valore, ma per tutti

👗 La moda sostenibile cresce verso un'industria più responsabile ed etica

🎧 Ma lo sai che abbiamo un sacco di newsletter?

📺 Trovi Fjona anche su RAI Play con Touch - Impronta digitale!

💌 Risolviamo i tuoi problemi di cuore con B1NARY

🎧 Ascolta il nostro imperdibile podcast Le vie del Tech

💸 E trovi un po' di offerte interessanti su Telegram!