È già un po’ di tempo che i dati vengono definiti “il nuovo petrolio“. Per estrarre il petrolio, abbiamo bisogno di pozzi e trivelle. Allo stesso modo, abbiamo bisogno di strumenti efficaci per gestire i dati moderni, che continuano ad aumentare in dimensione e complessità. Qlik è una di quelle aziende che fornisce l’equivalente di trivelle digitali per i dati: sistemi di analytics che estraggono informazioni da usare per la business intelligence. Perché come il petrolio alimenta, una volta raffinato, le nostre automobili, i dati raffinati alimentano le decisioni strategiche di un’azienda. Nel suo World Tour del 2023, Qlik fa il punto sullo stato dell’arte e affronta il problema della relazione tra dati e Business Intelligence.

Qlik World Tour

Il Qlik Wolrd Tour è un evento itinerante della multinazionale che, nel 2023, ha fatto tappa in Italia, a Milano, il 6 luglio. Nei singoli eventi locali si parla dei successi a livello corporate, ma si vanno anche a esaminare le situazioni specifiche del paese ospite.

Il World Tour del 2023 ha avuto anche un significato importante per Qlik in quanto ha demarcato i trenta anni di attività. Dopo tre decenni, l’azienda di origine svedese è una multinazionale con cinquanta sedi in tutto il mondo, 3.600 dipendenti e più di 40 mila clienti, di cui il 10% in Italia.

A parlarcene, durante il discorso di apertura, è stato Stefano Nestani, Senior Regional Director & Country Leader Italy di Qlik. Nel fare il quadro della situazione, Nestani riassume i successi recenti in tre punti. Innanzitutto, è stata costruita una piattaforma end-to-end per l’elaborazione dei dati in real-time. Secondo, l’intelligenza artificiale di cui oggi molti parlano è stata introdotta nei prodotti dell’azienda già cinque anni fa e oggi dispone già di un connettore OpenAI (chatGPT). Infine, è stata recentemente completata l’acquisizione di Talend ed è iniziata la fusione dal punto di vista delle infrastrutture.

Finita l’introduzione generale il microfono è passato a Dan Sommer, Senior Director Global Market Intelligence Lead di Qlik, che ci ha parlato dell’innovazione che l’azienda sta portando avanti.

L’innovazione di Qlik

Sommer racconta di Qlik parlando della sua esperienza personale. Il manager, infatti è arrivato in Qlik otto anni fa provenendo da Gartner. Questo vuol dire che, comunque, ha usato i prodotti della sua attuale azienda per almeno venti anni. Venti anni in cui Qlik è cambiata molto, e lo ha fatto perché anche i dati, e il modo che abbiamo di usarli, cono cambiati.

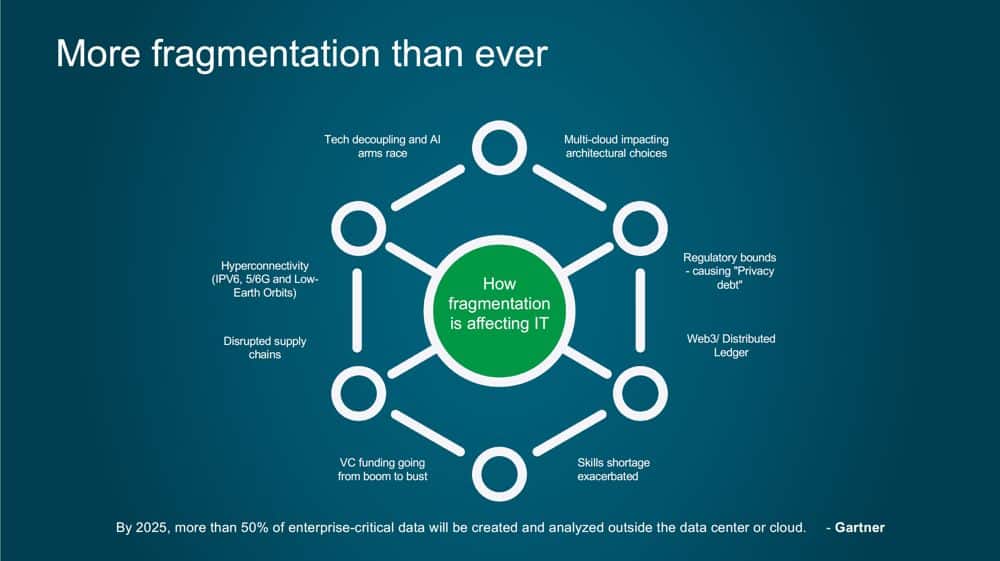

Quello che stiamo osservando oggi è un aumento della frammentazione dei dati con un conseguente effetto sulle tecnologie IT. Con il termine “frammentazione” si intende uno sparpagliamento sulla rete con la conseguente necessità di riaggregarli per poterli interpretare correttamente. Sono molti gli eventi e le innovazioni che stanno contribuendo a questa frammentazione; vanno dall’attuale conflitto in Ucraina fino alla prossima introduzione delle reti 6G. Secondo Gartner, nel 2025 più del 50% dei dati strategici delle multinazionali saranno generati e analizzati al di fuori di un loro data center o infrastruttura cloud. E questo, tecnicamente, sarà il prossimo passo dopo il cloud.

Quello che serve per affrontare il futuro sono nuovi approcci per l’elaborazione dei dati. I processi di business, che dipendono dai dati, dovranno diventare in tempo reale e al contempo elaborare molte più informazioni di quelle che usano oggi. Pertanto, è necessario fare degli investimenti sui dati per poter ottenere un vantaggio strategico. Secondo McKinsey, il 50% delle organizzazioni sta già usando l’Intelligenza Artificiale per migliorare i suoi processi decisionali.

Le linee guida per il trattamento dei dati

Se è vero che abbiamo bisogno di nuovi approcci per trattare i dati, allora serve darsi delle linee guida da seguire per poterli usare correttamente. Secondo Qlik, queste linee guida sono cinque.

Connect everything. I dati devono essere collezionati da tutte le sorgenti possibili e poi consolidati tra loro.

Proteggi i tuoi dati con Bitdefender, Leader in Cybersecurity

Business ready. I dati devono essere organizzati in un formato utilizzabile. Dobbiamo poterli prendere facilmente da dove sono memorizzati per creare nuovo business

Foresight. Guardare avanti ed essere innovativi nel modo di interpretare i dati. Questo perché oggi gli analisti tendono a portare le informazioni al di fuori dei processi di Business Intelligence per elaborarli.

Act. I dati devono essere usati per prendere decisioni che si trasformano in azioni concrete.

Trust. Doppiamo poterci fidare dei dati, delle decisioni che ci aiutano a prendere e delle informazioni che ne traiamo.

In particolare, l’aspetto della fiducia è essenziale. Si tratta di filtrare le informazioni false e capire se una sorgente dati è affidabile. Questo è il problema principale che oggi deve essere risolto.

I trend per il futuro

Guardando il futuro si possono cogliere due trend molto importanti. Da una parte sta cambiando il modo in cui gestiamo i dati e dall’altra come li analizziamo.

Per la parte di gestione, siamo partiti a inizio millennio con le Data Warehouse, oggi parliamo di Data Lake e di Cloud Data Warehouse. In futuro ci sposteremo su dei sistemi che potremmo chiamare Data Mesh o Data Fabric. Creare una Data Mesh vuol dire capire i metadati e la semantica dei dati. Ovverosia, capire tutte quelle informazioni che non fanno parte dei dati ma li contestualizzano. Questa operazione, però, è molto importante sia fatta con dei criteri di sicurezza e su dei volumi estremamente alti, a livello enterprise.

Per la parte di analisi, invece, siamo partiti dai report di Business Intelligence, oggi parliamo di analitiche visuali, ma il vero punto di arrivo è l’automazione intelligente. Cioè, processi di automazione che possono essere ottenuti con il supporto dell’Intelligenza Artificiale.

L’importanza di una Data Strategy

Nell’ultima parte dell’incontro interviene Michele Zanelli, Associate Partner di P4I – Partners4Innovation per parlaci dell’importanza per un’azienda di definire una strategia per il trattamento dei dati.

Zanelli sparte attaccando un luogo comune: oggi si parla molto di Generative AI, ma quella non può essere il prossimo passo. Bisogna prima parlare di data literacy, infrastrutture e data quality. Le aziende dovrebbero fare un percorso di crescita e non saltare direttamente sulle buzzword del momento.

In Italia, la spesa sulla Business Intelligence sta crescendo. È già cresciuta del 26% e crescerà di altrettanto nei prossimi cinque anni. Questo può essere interpretato come un segnale che le aziende hanno capito di dover investire nei dati. Alla fine, però, sussiste anche il rischio tangibile di trovarsi con una matassa di dati non strutturati e intrattabili. Questo potrebbe accadere perché usare i dati e gestirli sono due facce della stessa medaglia, che però sono difficili da mettere insieme. Molto spesso, infatti, troviamo risposte solo per una delle due metà.

Oggi, infatti, nelle aziende si inizia a parlare anche di Data Strategy.

Una Data Strategy è un piano a lungo termine che definisce la tecnologia, i processi, le persone e le regole necessarie per gestire le risorse informative di un’organizzazione

Una Data Strategy, quindi, definisce una serie di propositi per cui si intendono utilizzare le informazioni e introduce degli elementi di cui tenere conto. In più, deve essere collegata alla nostra strategia di business. Una Data Strategy non può operare in maniera indipendente dal contesto per il quale ci aiuta a prendere decisioni.

Tre esempi di Data Strategy di successo

L’intervento di Michele Zanelli prosegue con un momento di confronto in cui tre clienti Qlik condividono le loro storie e raccontano di come le rispettive aziende hanno definito la loro Data Strategy.

La prima testimonianza è di Michela Angiò, Responsabile Data Warehouse & Visualization presso Banca Widiba. Widiba è una banca nativa digitale molto giovane, con meno di 10 anni di storia. Durante la sua crescita ha realizzato di avere una serie di necessità relative ai dati e l’obiettivo della sua Data Strategy è stato semplicemente quello di semplificarne la fruizione. Nel loro caso, la direzione ha dato delle linee guida per la fruibilità dei dati sia lato business sia lato tecnico. Il problema più forte che hanno affrontato è stato il cambio di mentalità aziendale per poter abbandonare l’uso dei fogli excel.

Gianpiero Santesarti Application Production Digital Chapter Leader di BNL BNP Paribas ha presentato la realtà di un gruppo bancario che integra una grande varietà di organizzazioni. Avendo una storia importante per quanto riguarda le acquisizioni, Il problema principale per loro è quello di integrare tra loro piattaforme diverse in tempi brevissimi. Tutti i dati raccolti, nella loro visione, devono diventare una cosa unificata per poi convergere sul una singola piattaforma di home banking. Nel caso di BNL BNP Paribas, il problema più grande è la scalabilità: gestire grandissimi volumi di operazioni, nell’ordine dei milioni facendoli convergere in pochi secondi..

In chiusura c’è stata la testimonianza di Prysmian Group rappresentata da Mona Mohamed Mohiyeldin Soliman, Head of Data Office and Analytics. Prysmian Group è una multinazionale di stampo italiano con quartier generale ia Milano nel settore manifatturiero dell’energia. Per loro, l’aspetto più importante è riuscire a creare valore dai dati. Pertanto, le analytic sono una parte fondamentale della loro strategia produttiva, soprattutto per gli aspetti di logistica. È stato implementato un dashboarding di taglio direzionale con spending analysis, monitoraggio di produzione e indicatori di supply chain. Il problema più grande è stato generato dal fatto stesso di diventare una data-drive company. La richiesta di analytic interne cresce in maniera esponenziale e il gruppo di lavoro sui dati rischia di diventare il collo di bottiglia.

Rimani aggiornato seguendoci su Google News!

Da non perdere questa settimana su Techbusiness

🍎Indeed: che impatto avrà l’Intelligenza Artificiale sul futuro del lavoro?

☄️Data breach: le 8 cause principali della fuga di informazioni

🖥️Lavoro ibrido: i numeri del fenomeno e le soluzioni integrate di Logitech e Microsoft

🖨️FUJIFILM annuncia la serie Apeos, l'innovativa linea di stampanti multifunzione

✒️ La nostra imperdibile newsletter Caffellattech! Iscriviti qui

🎧 Ma lo sai che anche Fjona ha la sua newsletter?! Iscriviti a SuggeriPODCAST!

📺 Trovi Fjona anche su RAI Play con Touch - Impronta digitale!

💌 Risolviamo i tuoi problemi di cuore con B1NARY

🎧 Ascolta il nostro imperdibile podcast Le vie del Tech

💸E trovi un po' di offerte interessanti su Telegram!