Il mondo dell’intelligenza artificiale (AI) e del machine learning (ML) è in costante evoluzione, e il recente annuncio di Snowflake riguardo a Snowflake Arctic è un passo significativo in questa direzione. Snowflake Arctic è stato progettato per essere un large language model (LLM) aperto e all’avanguardia. Questo è in grado di offrire un’efficienza e un’intelligenza senza precedenti su vasta scala.

Ecco Snowflakes Arctic, il Large Language Model per le aziende

Prima di immergerci nei dettagli di Arctic, è importante capire il contesto in cui questo modello si inserisce. Secondo un recente report di Forrester, una percentuale significativa di responsabili delle decisioni aziendali ha adottato l’AI generativa come parte della strategia organizzativa. Questo indica un crescente interesse per modelli di intelligenza artificiale in grado di generare linguaggio naturale e comprendere il contesto delle conversazioni.

Sridhar Ramaswamy, CEO di Snowflake, durante la presentazione di Snowflake Arctic ha dichiarato che questo nuovo prodotto rivoluzionerà l’industria dell’AI. Arctic sarà in grado di offrire un livello di intelligenza ed efficienza che si posiziona al vertice del settore. Sridhar Ramaswamy ha concluso dicendo: “Come Snowflake, stiamo ridefinendo gli standard di ciò che l’intelligenza artificiale open source può raggiungere“.

Che cos’è in grado di fare Snowflake Arctic

Quello che rende Arctic un’innovazione rivoluzionaria è la sua natura aperta. Snowflake ha deciso di rilasciare il modello sotto licenza Apache 2.0, consentendo un uso senza restrizioni per scopi personali, di ricerca e commerciali. Questa mossa non solo promuove la collaborazione e l’innovazione nell’ambito dell’AI, ma stabilisce anche un nuovo standard di apertura per la tecnologia enterprise. Le novità non finiscono di certo qui, infatti, Arctic offre una gamma diversificata di modelli di codice e opzioni di inferenza e formazione altamente flessibili.

Questo consentirà agli utenti di avviare rapidamente la distribuzione e la personalizzazione di Arctic utilizzando i propri framework preferiti. Questi includono NVIDIA NIM con NVIDIA TensorRT-LLM, vLLM e Hugging Face. Inoltre, per chi desidera un utilizzo immediato, Arctic è disponibile per l’inferenza serverless in Snowflake Cortex, un servizio completamente gestito che offre soluzioni di machine learning e AI all’interno del Data Cloud di Snowflake. Oltre a Hugging Face, i clienti possono accedere ad altri modelli e cataloghi come Lamini, Microsoft Azure, NVIDIA API Catalog e Together.

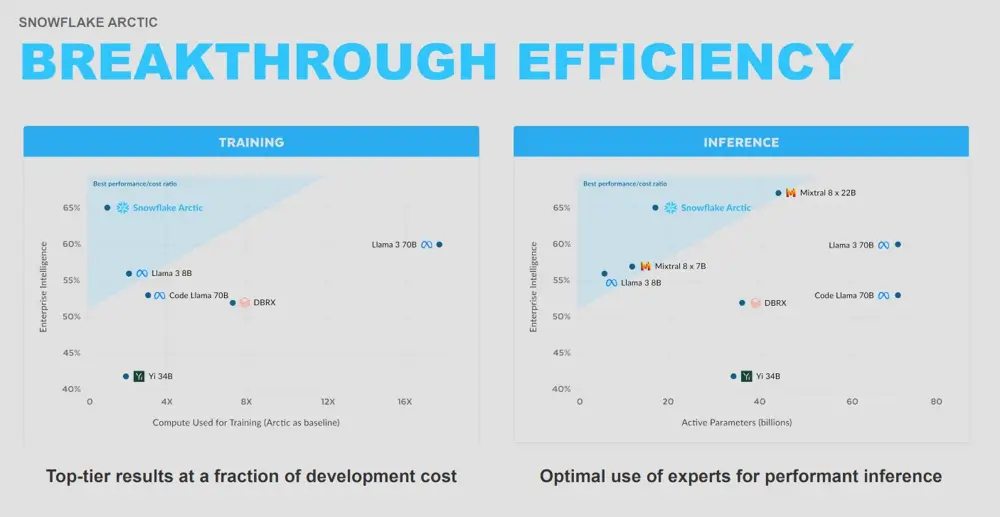

L’importanza di una gestione efficace delle risorse

Arctic garantisce un livello di intelligenza e al contempo un uso corretto ed efficace delle risorse. Il team di ricerca sull’AI di Snowflake, ha realizzato Arctic in meno di tre mesi e con un costo di formazione significativamente inferiore rispetto ai modelli simili. Grazie a questo impegno strategico, Snowflake sta stabilendo nuovi standard di velocità nell’addestramento dei modelli enterprise open source. Questo consentirà agli utenti di creare soluzioni su misura con un’efficienza ottimale su vasta scala.

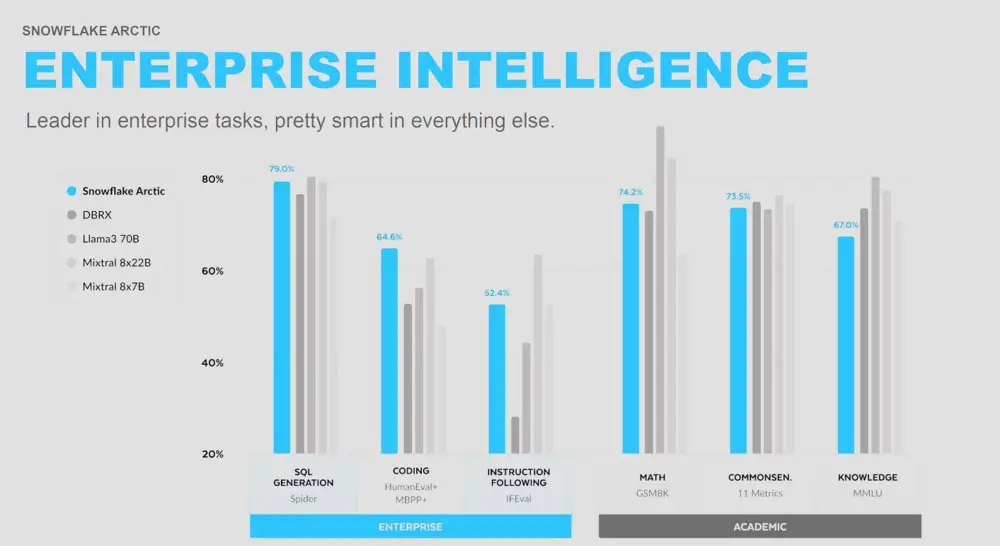

Il design differenziato dell’architettura Mixture-of-Experts (MoE) di Arctic contribuisce a migliorare sia i processi di addestramento che le prestazioni del modello. La sua composizione dei dati, attentamente progettata per rispondere alle esigenze aziendali, assicura risultati di alta qualità. Con l’abilitazione di 17 dei 480 miliardi di parametri contemporaneamente, Arctic ottiene un’efficienza senza precedenti nei token. In particolare, rispetto ad altri modelli come DBRX e Llama, Arctic attiva circa il 50% e l’75% in meno di parametri durante l’inferenza o l’addestramento. Inoltre, Arctic supera altri modelli aperti nei test di codifica e generazione di SQL, garantendo nel contempo ottime prestazioni nella comprensione del linguaggio naturale.

L’innovazione AI per tutti gli utenti

Snowflake si impegna costantemente ad accelerare l’innovazione nel campo dell’AI per tutti i suoi utenti. Fornisce alle aziende non solo la base di dati necessaria, ma anche i blocchi costruttivi avanzati per sviluppare applicazioni di AI e ML. Grazie all’accesso a Snowflake Cortex, Arctic aumenterà la capacità dei clienti di creare app AI, tutto all’interno di un ambiente sicuro come il Data Cloud.

La famiglia di modelli Snowflake Arctic non si limita al solo Arctic LLM, ma include anche Arctic embed, annunciato di recente. Questa serie di modelli di text embedding, disponibili per la comunità open source con licenza Apache 2.0, offre prestazioni di retrieval superiori a una frazione delle dimensioni dei modelli simili. Ottimizzati per l’utilizzo in combinazione con LLM come parte di servizi di Retrieval Augmented Generation o ricerca semantica. Questi modelli di embedding rappresentano una soluzione potente ed economica.

Inoltre, Snowflake offre accesso ai più recenti e potenti LLM del Data Cloud, tra cui le recenti aggiunte dei modelli Reka e Mistral AI. Attraverso una partnership ampliata con NVIDIA, Snowflake integra la piattaforma accelerata full-stack di NVIDIA nel suo Data Cloud. Fornendo, quindi una combinazione sicura di infrastrutture e capacità di calcolo per massimizzare la produttività dell’AI. Snowflake Ventures continua a investire in società come Landing AI, Mistral AI, Reka e altre, confermando l’impegno di Snowflake nell’aiutare i clienti a trarre valore dai propri dati aziendali utilizzando LLM e AI.

Rimani aggiornato seguendoci su Google News!

Da non perdere questa settimana su Techbusiness

📈 SAP NOW 2024 l'intelligenza artificiale per il business conquista Milano💸 Come calcolare il ritorno sugli investimenti nell’Intelligenza Artificiale

👨⚖️ Direttiva NIS2 e cybersecurity nelle PMI italiane obblighi e opportunità

🔫 Metà degli attacchi informatici in Italia prende di mira le supply chain

📰 Ma lo sai che abbiamo un sacco di newsletter?

📺 Trovi Fjona anche su RAI Play con Touch - Impronta digitale!

🎧 Ascolta il nostro imperdibile podcast Le vie del Tech

💸E trovi un po' di offerte interessanti su Telegram!