Tristano Ermini, Manager, Systems Engineering di Palo Alto Networks, ci parla dell’utilizzo dei modelli linguistici di grandi dimensioni (LLM) in ottica cloud, analizzando i pro e i contro dell’Intelligenza Artificiale.

Cosa sono gli LLM?

I modelli linguistici di grandi dimensioni (LLM) sono programmi di intelligenza artificiale che riescono a capire e produrre il linguaggio umano. Si basano su enormi quantità di dati testuali raccolti da Internet, dai quali apprendono le regole grammaticali e il modo di ragionare degli esseri umani. Queste capacità consentono agli LLM di risolvere problemi, creare contenuti e interagire con gli utenti. Alcuni esempi celebri di LLM sono ChatGPT di OpenAI, Bard di Google e il motore di ricerca Bing di Microsoft.

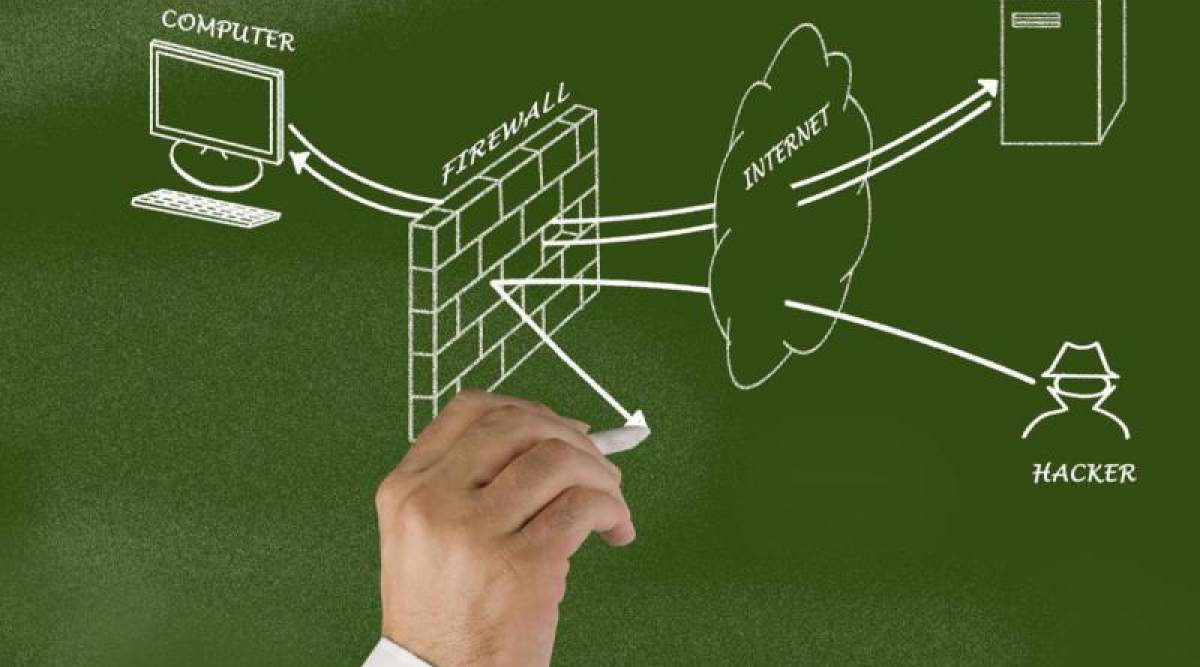

Gli LLMpossono essere sia una risorsa che una minaccia per la sicurezza dei sistemi cloud, che ormai dominano il settore tecnologico. Difatti, se da un lato questi modelli possono aiutare a proteggere i servizi e i dati che risiedono nel cloud, dall’altro possono generare disinformazione e vulnerabilità.

I principali rischi associati agli LLM in ottica cloud

Ecco le principali criticità evidenziate da Tristano Ermini:

- Allucinazione: gli LLM possono produrre output che non hanno alcun fondamento nell’input ricevuto o nella conoscenza del modello. Questo significa che il modello linguistico può creare un testo che non ha senso logico o semantico, ma che sembra plausibile a un osservatore umano.

- Pregiudizi: la maggior parte delle applicazioni LLM si basa su modelli già addestrati, perché costruire un modello da zero è troppo costoso per la maggior parte delle aziende. Tuttavia, nessun modello è perfettamente imparziale, perché i dati di addestramento sono sempre sbilanciati in qualche modo. Ad esempio, i dati potrebbero contenere più testi in inglese che in cinese o più informazioni sul liberalismo che sul conservatorismo. Questo può portare a decisioni errate o ingiuste da parte degli esseri umani che si affidano ai suggerimenti dei modelli.

- Coerenza: gli LLM non producono sempre lo stesso output a partire dallo stesso input: sono modelli probabilistici che continuano a “indovinare” la parola successiva in base a certe distribuzioni di probabilità.

- Elusione dei filtri: gli strumenti LLM sono solitamente dotati di filtri di sicurezza per evitare che i modelli generino contenuti indesiderati, come quelli per adulti, violenti o protetti da diritti d’autore. Tuttavia, questi filtri possono essere elusi in alcuni casi, ad esempio, modificando gli input (prompt injection attack). I ricercatori hanno mostrato diverse tecniche per far generare a ChatGPT testi offensivi o previsioni infondate.

- Privacy: gli LLM possono solo elaborare input e output non criptati in cloud. Quando un modello proprietario viene offerto come servizio, ad esempio OpenAI, i fornitori di servizi accumulano una grande quantità di informazioni sensibili o riservate, la cui compromissione potrebbe essere disastrosa, come dimostrato dai recenti casi di takeover di account e incidenti di query trapelate.

Le sfide che il settore dovrà affrontare

I rischi sopra elencati possono facilmente tramutarsi in sfide per i vari settori digitali (e non). In particolare:

- Fake news e disinformazione: grazie alle loro avanzate capacità di generazione del linguaggio, gli LLM possono creare contenuti convincenti, basati su input verosimili ma falsi, contribuendo alla diffusione di fake news, teorie cospirative o narrazioni con intenti negativi.

- Attacchi di social engineering: i malintenzionati possono utilizzare gli LLM per creare sofisticati attacchi di social engineering, come le e-mail di spear phishing e contenuti basati sul deep fake.

- Violazione della proprietà intellettuale: gli LLM possono essere utilizzati per generare contenuti molto simili a materiale protetto da diritti d’autore. Ciò rappresenta un rischio per le aziende che si affidano alla proprietà intellettuale per mantenere un vantaggio competitivo.

- Creazione di strumenti di attacco: l’AI generativa è stata utilizzata per verificare codice sorgente e scrivere nuovo codice e i ricercatori hanno dimostrato che può anche scriverne di pericolosi, come i ransomware. Ulteriori ricerche dimostrano che i criminali informatici usano ChatGPT anche per creare script di attacco.

LLM e AI: anche opportunità per il cloud

I modelli linguistici di grandi dimensioni non rappresentano solamente un rischio potenziale, ma possono anche assumere un ruolo positivo. Difatti, se usati correttamente, possono essere sfruttati anche per migliorare la sicurezza cloud. Vediamo alcuni casi d’uso degli LLM nella sicurezza cloud:

- Automatizzare il rilevamento e la risposta alle minacce. Uno dei vantaggi più significativi degli LLM nel contesto della sicurezza cloud è la capacità di ottimizzare i processi di rilevamento e risposta alle minacce. Unendo la comprensione del linguaggio naturale, tipica degli LLM, alla Precision AI (Machine Learning o Deep Learning), si possono identificare potenziali minacce nascoste in grandi volumi di dati e modelli di comportamento degli utenti. Inoltre, imparando continuamente da nuovi dati, è possibile adattarsi alle minacce emergenti. In tal modo si ottengono informazioni sui rischi in tempo reale, consentendo alle aziende di rispondere in modo rapido ed efficiente agli incidenti di sicurezza.

- Migliorare la conformità alla sicurezza: con la continua evoluzione dei quadri normativi, le aziende devono affrontare la sfida della compliance rispetto a vari standard e requisiti di sicurezza. Gli LLM possono essere utilizzati per analizzare e interpretare i testi normativi, consentendo di comprendere e implementare facilmente i controlli di protezione necessari. Automatizzando la gestione della conformità, possono ridurre significativamente l’impegno dei team di sicurezza, consentendo loro di concentrarsi su altre attività fondamentali. Questo aspetto è estremamente importante per le soluzioni che richiedono un elevato livello di conformità. E lo è ancora di più quando il cliente che le gestisce desidera rispettare determinate normative.

- Prevenzione degli attacchi di social engineering: gli attacchi di social engineering, come il phishing e il pretexting, sono tra le minacce più diffuse alla sicurezza cloud. Utilizzando gli LLM per analizzare i modelli di comunicazione e identificare i potenziali rischi, le aziende possono rilevare e bloccare in modo proattivo gli attacchi di social engineering. Grazie a capacità avanzate di comprensione del linguaggio, gli LLM sono in grado di discernere le sottili differenze tra comunicazioni legittime e dannose. L’AI fornisce quindi un ulteriore livello di protezione per i sistemi basati su cloud.

- Migliorare la comunicazione della risposta agli incidenti: quando si parla di sicurezza cloud, un aspetto critico dell’incident response è rappresentato dall’efficacia dei processi di comunicazione. Gli LLM possono essere utilizzati per generare report accurati e tempestivi. Rendendo quindi più facile per i team di sicurezza comprendere la natura degli incidenti e coordinare le attività di risposta. Inoltre, possono essere adottati per creare comunicazioni chiare e concise con gli stakeholder. In questo modo si possono aiutare le aziende a gestire i rischi per la reputazione associati alle violazioni di sicurezza.

Considerazioni finali di Tristano Ermini

“Come abbiamo visto, gli LLM presentano sia vantaggi che rischi per la sicurezza cloud. In particolare, essi aumentano il rischio che i dipendenti delle organizzazioni diffondano dati sensibili attraverso le applicazioni di Generative AI, violando la conformità o i requisiti normativi. Palo Alto Networks offre ai propri clienti un CASB di nuova generazione, in grado di identificare e bloccare l’accesso a interi cataloghi di app di Gen AI non autorizzate, che possono mettere a rischio utenti e dati. Inoltre, per le app consentite, il CASB può impedire la dispersione di dati sensibili su ChatGPT e altre app di uso comune, ad esempio quando gli utenti incollano codice sorgente o dati personali e/o sensibili negli appositi campi di queste applicazioni”

Tristano Ermini, Manager, Systems Engineering di Palo Alto Networks

- VI PRESENTIAMO LE SONY WH-1000XM5: le nostre migliori cuffie wireless con Noise Cancelling imbattibile, qualità del suono cristallina, qualità delle chiamate leader di settore, comfort di lusso e molto altro ancora.

- NOISE CANCELLING LEADER DI SETTORE: ora con quattro microfoni su ciascun padiglione auricolare, i suoni indesiderati vengono eliminati in modo più accurato. Il nostro ottimizzatore NC automatico garantisce che la cancellazione del rumore sia ottimizzata per il tuo ambiente.

- QUALITÀ DEL SUONO PREMIUM: la nostra unità driver progettata con precisione migliora la sensibilità alle alte frequenze e l'audio ad alta risoluzione è supportato grazie a LDAC, la nostra tecnologia di codifica audio adottata dal settore.

- BATTERIA A LUNGA DURATA: la batteria da 30 ore ti offre energia sufficiente per lunghi viaggi. Per una ricarica rapida, un adattatore CA USB-PD (venduto separatamente) fornisce 3 ore di riproduzione con una ricarica di 3 minuti.

- CONCEDITI UN COMFORT DI LUSSO: Realizzati con materiali di prima qualità in un design ergonomico, i morbidi cuscinetti auricolari cullano le tue orecchie, mentre l'archetto regolabile garantisce una vestibilità su misura per diverse ore di utilizzo.

Rimani aggiornato seguendoci su Google News!

Da non perdere questa settimana su Techbusiness

📈 SAP NOW 2024 l'intelligenza artificiale per il business conquista Milano💸 Come calcolare il ritorno sugli investimenti nell’Intelligenza Artificiale

👨⚖️ Direttiva NIS2 e cybersecurity nelle PMI italiane obblighi e opportunità

🔫 Metà degli attacchi informatici in Italia prende di mira le supply chain

📰 Ma lo sai che abbiamo un sacco di newsletter?

📺 Trovi Fjona anche su RAI Play con Touch - Impronta digitale!

🎧 Ascolta il nostro imperdibile podcast Le vie del Tech

💸E trovi un po' di offerte interessanti su Telegram!