La settimana scorsa si è tenuto a Milano, nella splendida cornice dell’Hotel Gallia, l’evento “AI & HPC: Reshaping the Business Landscape” organizzato da E4 Computer Engineering. L’incontro era rivolto a partner e clienti con l’obiettivo di fare il punto su come l’intelligenza artificiale e l’High Performance Computing stiano trasformando il panorama economico mondiale.

È noto a tutti che AI e HPC sono due tecnologie profondamente interconnesse. L’intelligenza artificiale, infatti, richiede enormi capacità di calcolo per poter essere sfruttata appieno. D’altro canto, l’AI è oggi uno dei principali motori per i servizi sia consumer che business offerti sul mercato. Pertanto, la sua crescente popolarità ha generato ingenti investimenti per lo sviluppo dell’HPC. Questa evoluzione si misura su due fronti principali: da un lato, la densità di calcolo disponibile per metro cubo; dall’altro, il consumo energetico richiesto per eseguire i calcoli.

E4 Engineering

Gli onori di casa li fa, ovviamente, E4, rappresentata da Cosimo Gianfreda, CEO e co-founder.

E4 è un’azienda nata in Italia con l’obiettivo iniziale di fornire servizi di HPC. A partire da questi, si è poi allargata a tecnologie in grado di capitalizzare su una forte capacità di calcolo, come il data analytics e il quantum computing. In maniera abbastanza naturale, insieme al data analytics, sono arrivati anche i sistemi di storage su larga scala (come quello che l’azienda ha fornito al CERN).

Nella visione di E4, l’intelligenza artificiale porterà un cambiamento nelle nostre vite paragonabile a quanto fatto dal GPS nelle nostre abitudini di spostamento. Questo aspetto le è sempre stato ben chiaro; infatti, l’azienda parlava già di AI nel 2017, come testimoniato da un suo evento a Bologna.

La filosofia con cui E4 porta innovazione è quella di farsi guidare dai bisogni dei propri utenti per tutte le attività di ricerca e sviluppo volte all’esplorazione di scenari futuri. Tra le loro installazioni più importanti dove questa filosofia è stata applicata figurano il supercomputer per l’Istituto Italiano di Tecnologia e il Tecnopolo di Bologna. Nel primo caso è stata costruita un’infrastruttura di servizi di base per permettere al cliente di usare facilmente i proprio applicativi; nel secondo sono state fatte sperimentazioni per il raffreddamento a liquido.

E4 Analytics

Di E4 Analytics, lo spinoff di E4 che si occupa di fornire strumenti per l’analisi dei dati, ce ne ha parlato il suo CEO, Mario Rosati.

L’obiettivo di E4 Analytics è molto semplice: semplificare l’AI e renderla accessibile. Perché il modo in cui i dati si integrano con l’intelligenza artificiale definisce un ecosistema estremamente complesso. Ogni passo del processo di elaborazione vede coinvolti strumenti molto difficili sia da utilizzare sia da integrare tra loro.

E4 Analytics vuole contribuire alla semplificazione dell’ecosistema attraverso due progetti. Il primo è ICE4HPC, nel quale si cerca di fornire a chi fa AI strumenti a lui familiari anche su una piattaforma di HPC. Il secondo progetto si chiama Urania ed è una piattaforma completa (end-to-end) per lo sviluppo di modelli di AI.

Strumenti del genere diventano sempre più necessari perché oggi, secondo le indagini, il 55% delle aziende sta pensando di creare un proprio LLM. Questo perché l’AI generativa è vista come una grande opportunità dal tessuto industriale. L’intenzione di creare un proprio LLM, però, si scontra anche con un tema di fuga delle informazioni, soprattutto attraverso i sistemi di chatbot.

La soluzione di E4 Analytics prende il nome di Private LLM. Un LLM privato è un modello di AI che viene installato pre-addestrato e poi continua a evolvere usando solo dati interni al cliente. In questo modo è possibile preservare non solo la sovranità dei dati ma anche la loro protezione. Un LLM di questo tipo è anche alla base di GAIA. GAIA è il prodotto di E4 Analytics per uso privato proposto commercialmente come alternativa a ChatGPT.

Rosati conclude il suo intervento dicendo che la AI generativa non è una moda passeggera ma è invece destinata a rimanere e a cambiare il modo in cui lavoriamo.

Il punto di vista di NVIDIA

NVIDIA è il primo ospite a parlare, rappresentata da Rod Evans: VP High Performance Computing & AI. Ovviamente, quello che ha offerto NVIDIA è stato un punto di vista da leader di mercato.

Siamo di fronte a un grande cambiamento a livello industriale. Un cambiamento che, seppure ci porta dalle CPU alle NPU (Neural Processing Unit), non riguarda solo l’hardware. La trasformazione di cui ci racconta Evans, infatti, vede anche una transizione dalla fabbricazione di software alla fabbricazione di AI.

Questo fenomeno andrà a creare una grande capacità di generare informazioni e risolvere problemi tramite AI. Pertanto, l’AI generativa verrà usata per una serie di attività nuove come la manutenzione e la ristrutturazione del codice. Inoltre, sempre secondo Evans, ne usciranno molto potenziati i digital twins per cui ci sarà un’esplosione della simulazione come alternativa della pianificazione logistica.

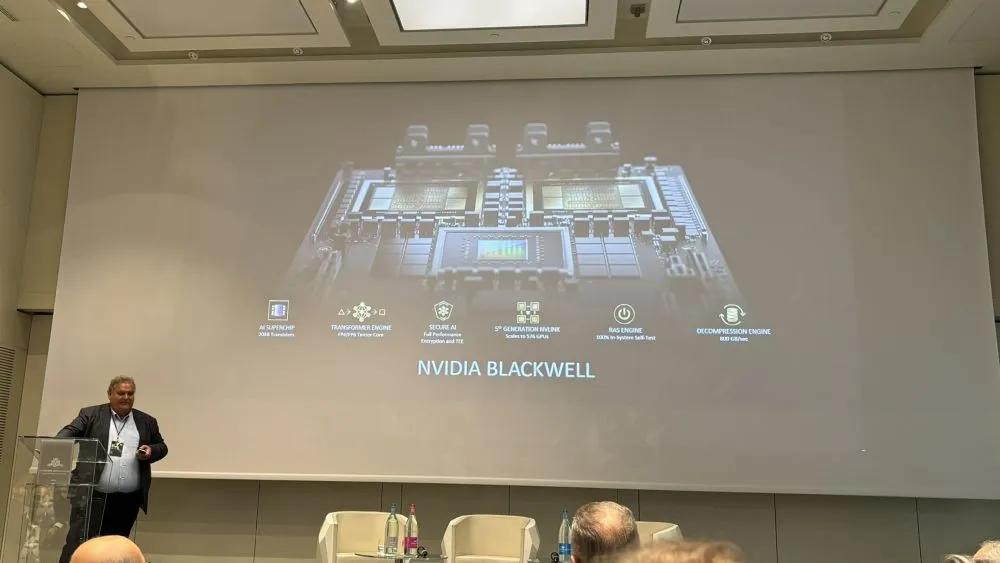

Quello che deve succedere, ora, è portare l’intelligenza artificiale in produzione. Ovvero, lasciarsi alle spalle l’eccitazione del momento e farla diventare effettivamente parte dei processi produttivi. L’effetto sarà però anche un incremento drastico della richiesta energetica, con tutte le conseguenze del caso. La risposta di NVIDIA a questo problema sarà contenuta nella nuova generazione della sua piattaforma tecnologica (NVIDIA Blackwell) e nei NIM (NVIDIA Inference Microservices). Per ora il manager non ha potuto darci molti dettagli, ma ci ha garantito che vedremo interessanti novità a breve.

I trend per il futuro

Sul palco sono poi saliti una serie di esperti per parlare dei trend del futuro. In particolare, sono intervenuti Claudio Bellini (HPC Account Executive per Italia e Svizzera, di Intel), Luca Catalano (Sales Executive di AMD), Rod Evans (di NVIDIA) e Nick Brown (Senior Research Fellow dell’Università di Edimburgo). La discussione è stata piuttosto articolata, ma tutti i partecipanti sono andati hanno dimostrato di convergere più o meno sulle stesse linee guida.

Dal punto di vista delle soluzioni tecniche, siamo in una situazione in cui le GPU non possono più stare alla periferia delle piattaforme, ma devono essere spostate al centro. Il loro utilizzo, oggi, può fare la differenza per molte applicazioni di compressione, crittografia e gestione di contenuti multimediali. Le piattaforme, però, devono espandersi e potenziarsi per accogliere tutta questa capacità computazionale; altrimenti rischiano di diventare loro stesse il collo di bottiglia per le prestazioni.

Il tema del consumo energetico è saltato fuori nuovamente in parecchie occasioni. Emerge però un interessante discorso sulla distinzione tra l’energia necessaria all’addestramento di una AI e quella necessaria per usarla. Pare infatti che la prima sia preponderante. Questo, al di là degli evidenti problemi di scalabilità che implica, potrebbe voler anche dire che serve dare agli sviluppatori degli strumenti che, oltre a essere open, creino anche codice energeticamente efficiente.

Rimani aggiornato seguendoci su Google News!

Da non perdere questa settimana su Techbusiness

📈 SAP NOW 2024 l'intelligenza artificiale per il business conquista Milano💸 Come calcolare il ritorno sugli investimenti nell’Intelligenza Artificiale

👨⚖️ Direttiva NIS2 e cybersecurity nelle PMI italiane obblighi e opportunità

🔫 Metà degli attacchi informatici in Italia prende di mira le supply chain

📰 Ma lo sai che abbiamo un sacco di newsletter?

📺 Trovi Fjona anche su RAI Play con Touch - Impronta digitale!

🎧 Ascolta il nostro imperdibile podcast Le vie del Tech

💸E trovi un po' di offerte interessanti su Telegram!