Secondo un proverbio cinese, “L’acqua che sostiene la barca può anche farla affondare”: nel caso delle aziende, l’acqua è rappresentata dall’AI generativa, che è sia fonte di opportunità che di potenziali minacce. Ma quali sono i principali rischi introdotti dall’AI generativa, e come fare per mitigarli? Ce ne parla Emiliano Massa, Area Vice President, Sales SEUR, Proofpoint.

Fidarsi è bene, ma non fidarsi è meglio

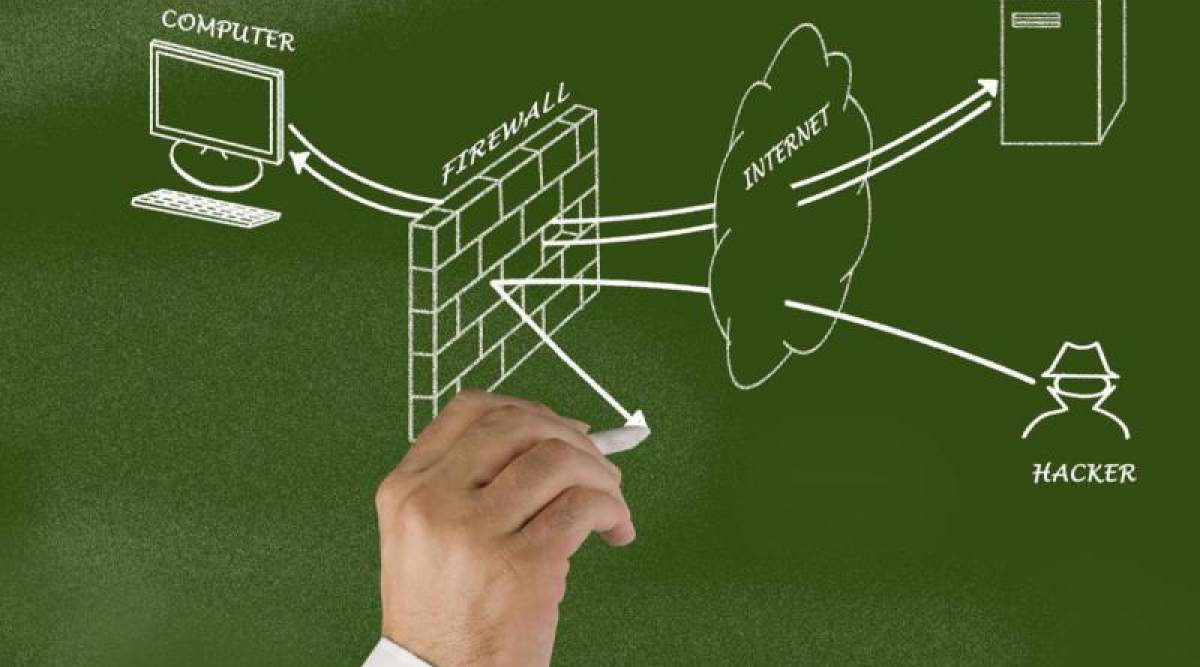

È passato il tempo in cui bastava controllare gli errori grammaticali per distinguere un messaggio genuino da uno di phishing. L’intelligenza artificiale, in questo caso purtroppo, conosce bene la struttura grammaticale di qualsiasi lingua.

Data la capacità dell’AI generativa di creare messaggi convincenti in qualunque lingua a partire da un singolo prompt, non è un caso che il numero di incidenti di phishing siano in aumento. Nel report “2024 State of the Phish“, Proofpoint ha infatti rilevato un incremento degli attacchi BEC (Business Email Compromise), guidato proprio dall’ascesa dell’AI generativa.

Difendersi dal phishing è difficile, ma non impossibile. Ricordiamo l’adagio “fidarsi è bene, ma non fidarsi è meglio“: trattiamo ogni mittente come potenziale sospetto. Inoltre, prestiamo attenzione ad altri segnali di phishing, come il senso di urgenza, un mittente inaspettato, la mancata corrispondenza tra il nome visualizzato e l’indirizzo email del mittente e la richiesta di pagamento o di dati sensibili.

Facciamo attenzione ai dati che inseriamo nei chatbot

Forse tendiamo a confidarci un po’ troppo con gli strumenti di AI generativa. Un documento di lavoro qui, del codice sorgente sensibile là… tanto è tutto al sicuro, vero?

Non proprio. I siti di AI generativa o le chatbot di AI possono memorizzare tutte le informazioni condivise con loro, e questi dati vengono utilizzati per addestrare i modelli e migliorare le loro prestazioni. Di conseguenza, potrebbero accidentalmente condividere dati sensibili con altri utenti, sia all’interno che all’esterno dell’azienda.

Consigliamo perciò di non condividere informazioni o caricare dati sensibili, dato che ciò potrebbe comportare perdita della proprietà intellettuale, violazioni normative e di dati.

L’AI non può sbagliare… vero?

Le chatbot AI paiono onniscienti, e per certi versi lo sono, dato che i modelli su cui si basano sono stati addestrati milioni di libri, pagine web e articoli scientifici. Tuttavia, tendono a essere un po’ spavalde della loro conoscenza, e non ammetteranno mai di non sapere qualcosa. E se dovessimo chiedere loro qualcosa che non possono sapere? Si inventeranno una risposta plausibile. Questo fenomeno è chiamato “allucinazione AI“.

Facciamo qualche esempio. Un chatbot potrebbe generare un testo o un’affermazione che pare corretta, ma in realtà non lo è, o lo è solo parzialmente. Oppure, potrebbe generare dati falsi su un’entità o una persona reale, inserendo elementi errati, che alcuni utenti potrebbero considerare veritieri. O ancora, potrebbe generare un’affermazione generale senza fornire agli utenti tutte le informazioni necessarie.

Vi raccomandiamo di nutrire sempre un po’ di sano scetticismo nei confronti delle risposte generate dall’AI generativa, e di effettuare ricerche da altre fonti per verificare che tutto ciò che affermano sia vero. Inoltre, ricordiamo che molte chatbot non sono progettate per usi specifici, come ad esempio condurre ricerche scientifiche, citare leggi e casi o prevedere il tempo. Forniranno comunque una risposta, che potrebbe però non essere accurata.

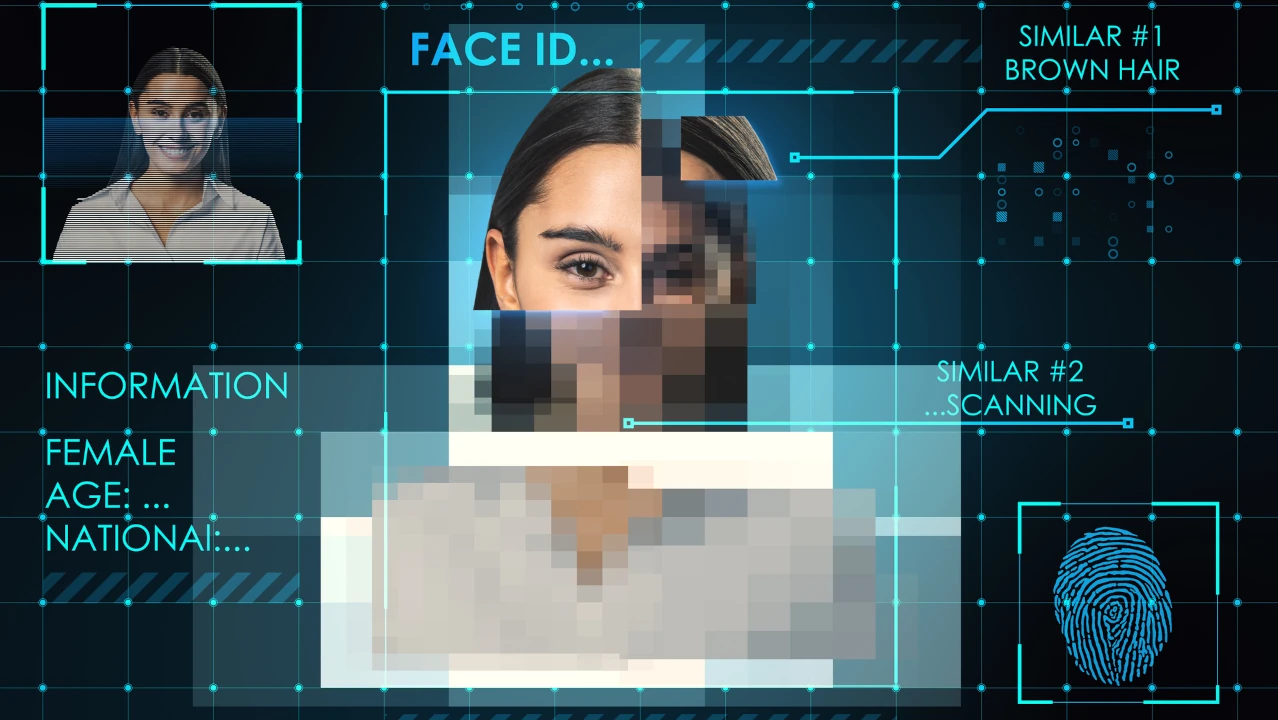

A volte, gli occhi possono ingannare: allarme deepfake

Facciamo prima un po’ di chiarezza: i deepfake sono immagini o video falsi generati dall’intelligenza artificiale e manipolati per sostituire il volto o la voce di una persona. La tecnologia utilizzata per generarli è una forma specifica di machine learning chiamata deep learning.

I deepfake non sono una novità ed esistono da anni, ma gli strumenti di AI generativa rendono il processo di creazione molto più semplice ed economico poiché vengono utilizzati algoritmi per generare contenuti basati su esempi e dati esistenti.

Purtroppo, i deepfake sono diventati un’ottima arma per i criminali informatici per sferrare attacchi, soprattutto alle grandi aziende. I malintenzionati possono utilizzare i deepfake per impersonare ruoli dirigenziali, come il CEO o il CFO, e forzare pagamenti fraudolenti.

Non esiste una tecnologia o una soluzione in grado di rilevare e bloccare efficacemente i deepfake dannosi. L’approccio migliore è puntare sulla formazione, stabilire un processo interno all’azienda e creare policy di mitigazione, ad esempio richiedendo sempre una convalida su un altro canale.

- Kaplan, Jerry (Autore)

Rimani aggiornato seguendoci su Google News!

Da non perdere questa settimana su Techbusiness

🎵 Synology al Nameless Festival

🧑💻 La rivoluzione dello sviluppo software operata dall'Intelligenza Artificiale

🫵 Le imprese e la trasformazione digitale: il punto della situazione

🚙 Il futuro dell'automotive nel 2025; auto sempre più smart e connesse

📰 Ma lo sai che abbiamo un sacco di newsletter?

📺 Trovi Fjona anche su RAI Play con Touch - Impronta digitale!

🎧 Ascolta il nostro imperdibile podcast Le vie del Tech

💸E trovi un po' di offerte interessanti su Telegram!