Nonostante l’uso delle applicazioni di AI generativa sia in costante aumento, le aziende fanno ancora fatica a trovare un equilibrio tra abilitazione sicura e gestione del rischio. Una nuova ricerca di Netskope infatti rivela che i dati regolamentati costituiscono più di un terzo dei dati condivisi con applicazioni di AI generativa: ciò si traduce in potenziali rischi per le aziende.

Il report, dal titolo “Cloud and Threat Report: AI Apps in the Enterprise” si basa su un sondaggio che ha coinvolto centinaia aziende provenienti da diversi settori, inclusi quello finanziario, sanitario, telco, manifatturiero e retail. Le statistiche si basano su un periodo di tredici mesi che va dal primo giugno 2023 al 30 giugno 2024.

Come stanno affrontando questo rischio le aziende?

Quasi tutte le aziende ormai utilizzano, in una forma o in un’altra, l’AI generativa. Il report rivela infatti che ben il 96% delle aziende la utilizza, un numero che è triplicato negli ultimi 12 mesi. In media, le aziende ora utilizzano quasi 10 applicazioni di AI generativa, rispetto alle 3 dell’anno scorso, con l’1% degli utenti che ora utilizza una media di 80 applicazioni, in aumento rispetto alle 14. Tra queste, l’applicazione più utilizzata è ChatGPT, impiegata da oltre l’80% delle aziende. Microsoft Copilot ha invece registrato la crescita più significativa nell’utilizzo dal suo lancio nel gennaio 2024, pari al 57%.

Parallelamente all’aumento dell’utilizzo, le aziende hanno registrato un aumento della condivisione del codice sorgente proprietario all’interno delle applicazioni di AI generativa, che rappresenta il 46% di tutte le violazioni documentate di policy di prevenzione della perdita di dati (data loss prevention, DLP).

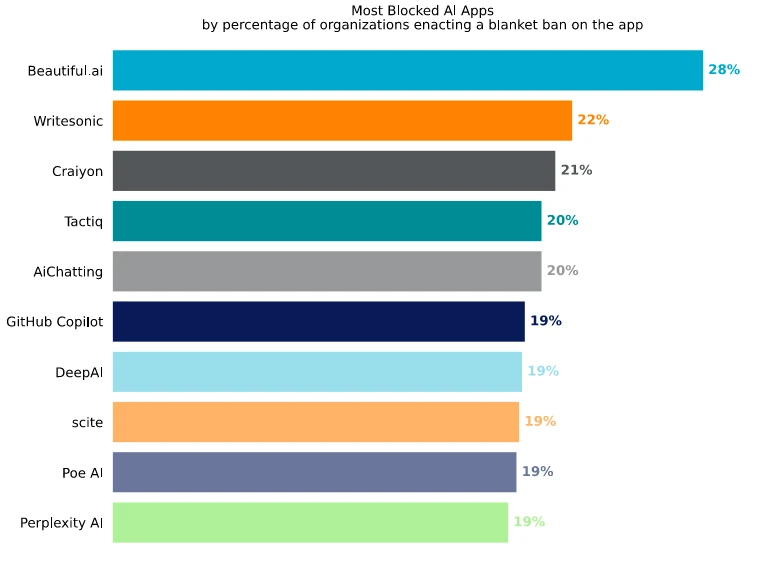

Le aziende stanno cercando di porre freno alla condivisione inappropriata dei dati sensibili, dato che dalla ricerca emerge che tre quarti delle aziende intervistate ora bloccano completamente almeno un’applicazione di AI generativa. Tuttavia, molte di queste aziende sono ancora un passo indietro nell’adottare soluzioni avanzate di data loss prevention necessarie per abilitare in sicurezza dell’AI generativa. Infatti, meno della metà delle aziende applica controlli incentrati sui dati per impedire la condivisione di informazioni sensibili nelle richieste di input degli utenti.

Il metodo migliore è un approccio proattivo

Il divieto assoluto non è quindi efficace. Lo è invece la gestione proattiva del rischio, che alcune aziende stanno applicando. Ad esempio, il 65% delle aziende ora implementa il coaching per gli utenti in tempo reale per guidare le interazioni degli utenti con le applicazioni di AI generativa. Sempre secondo la ricerca, un efficace coaching degli utenti ha svolto un ruolo cruciale nel mitigare i rischi relativi ai dati, spingendo il 57% degli utenti a modificare le proprie azioni dopo aver ricevuto avvertimenti a riguardo.

“La protezione della genAI richiede ulteriori investimenti e maggiore attenzione poiché il suo utilizzo permea le aziende, senza segnali di rallentamento nel breve periodo”, ha affermato James Robinson, Chief Information Security Officer, Netskope. “Le aziende devono riconoscere che i risultati ottenuti dalla genAI possono inavvertitamente esporre informazioni sensibili, diffondere disinformazione o persino introdurre contenuti malevoli. Richiede un solido approccio alla gestione del rischio per salvaguardare i dati, la reputazione e la continuità aziendale”.

I consigli di Netskope per le imprese

Dato che i dati emersi dallo studio sono ben poco rosei, Netskope consiglia alle imprese di rivedere, adattare e personalizzare i propri framework di rischio specificamente per l’intelligenza artificiale o l’AI generativa. Questo è possibile utilizzando iniziative come il framework di gestione del rischio AI del NIST.

Per adottare i framework di sicurezza, Netskope consiglia di valutare gli usi esistenti dell’intelligenza artificiale e dell’apprendimento automatico, delle pipeline di dati e delle applicazioni di AI generativa, e di identificare le vulnerabilità e le lacune nei controlli di sicurezza.

Netskope consiglia inoltre di stabilire misure di sicurezza fondamentali, come controlli di accesso, meccanismi di autenticazione e crittografia. Una volta stabilite le misure base, è importante sviluppare una tabella di marcia per controlli di sicurezza avanzati. Questo significa prendere in considerazione la modellazione delle minacce, il rilevamento delle anomalie, il monitoraggio continuo e il rilevamento comportamentale per identificare i movimenti di dati sospetti negli ambienti cloud verso le applicazioni di AI generativa che si discostano dai normali modelli utente.

Le misure di sicurezza dovrebbero variare nel tempo, in modo da potersi adattare allo scenario della cybersecurity in continuo cambiamento. Serve quindi valutare regolarmente l’efficacia delle misure di sicurezza.

Per maggiori informazioni, vi invitiamo a consultare il report completo disponibile sul sito web di Netskope.

- Hernandez, Dr. Felix (Autore)