A valle di re:Invent 2024, il grande evento di AWS da poco tenutosi a Las Vegas, la multinazionale fa il punto sugli annunci e sulle innovazioni dell’ultimo anno. Nel 2024, AWS ha lavorato principalmente sull’intelligenza artificiale, come tutte le grandi multinazionali di oggi, ma ha anche introdotto una serie di novità a livello infrastrutturale e nei suoi servizi orientati ai clienti business. Cerchiamo di capire quali sono i trend principali e le novità più importanti di una delle più grandi multinazionali del cloud.

AWS e L’Intelligenza Artificiale come componente di base

L’importanza dell’AI per AWS è dimostrata dal fatto che l’azienda la inserisce direttamente nelle fondamenta della sua infrastruttura software.

Da sempre, ad AWS piace definire il suo cloud come “il cloud dei builder“, perché l’idea è quella di costruire soluzioni componendo gli elementi disponibili al suo interno. Oggi, ai tre raggruppamenti principali e fondanti: compute, storage e database, se ne aggiunge un quarto: l’inferenza. Per cui, da qui in poi, sarà possibile utilizzare funzionalità di intelligenza artificiale disponibili in maniera nativa su AWS per comporre architetture software.

I componenti dell’AI di AWS

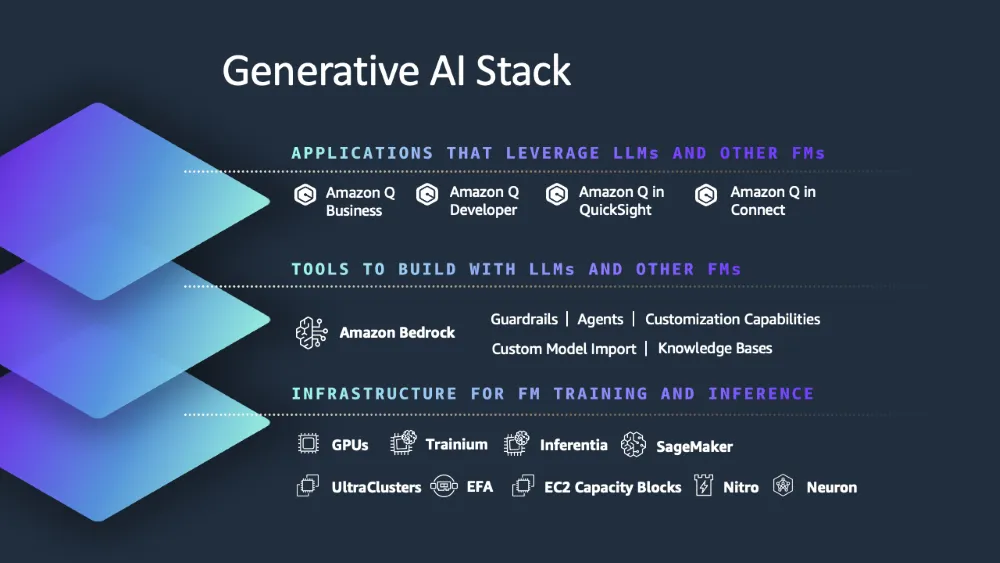

La parte nativa di intelligenza artificiale di AWS si compone fondamentalmente di tre moduli: Bedrock, SageMaker e Amazon Q. Questi tre moduli definiscono uno stack software che parte dai modelli di AI di Bedrock per arrivare all’intelligenza artificiale fornita come servizio SaaS tramite Amazon Q.

Bedrock

Bedrock implementa il livello di astrazione più basso. Si occupa di fornire tutte le funzioni di base per l’AI all’interno di AWS. Bedrock vuole essere un servizio gestito interamente da AWS, in grado di consentire agli sviluppatori un accesso semplice e sicuro alle funzionalità di AI. L’idea di base è offrire a chi sviluppa un ventaglio di scelte il più ampio possibile.

All’interno di Bedrock troviamo Amazon Nova: una collezione di modelli fondazionali di AI che possono essere addestrati e utilizzati. I modelli gestiti tramite Amazon Nova sono attualmente sei, ma offrono già una buona varietà di modalità di interazione: si va dal solo testo ai multimodali, fino ad arrivare ai multimediali per generare immagini e video. I modelli si differenziano per la velocità con cui forniscono le risposte, nonché per la precisione e l’affidabilità di queste ultime. L’obiettivo è quello di offrire sempre all’utente la risposta più energeticamente conveniente. La taratura energetica, infatti, è la discriminante che determina il costo dei singoli modelli.

Alcune novità di Bedrock

Oltre ai nuovi modelli di AI, Bedrock si arricchisce anche di nuove funzionalità. Tra le più interessanti troviamo un marketplace per i modelli; sarà possibile pubblicare e acquistare modelli di terze parti partner di Amazon. Inoltre, ci sono una serie di novità più tecniche.

Per la gestione dei prompt è stato introdotto un sistema di cache (per ridurre i calcoli e risparmiare molta energia) e un routing intelligente per indirizzare la richiesta al modello più adatto, anche dal punto di vista energetico.

Esiste ora la possibilità di fare model distillation, ovvero raffinare un modello complesso per crearne altri più piccoli e verticali (e meno costosi) per risolvere un problema specifico. Associato a questo, c’è ora anche una funzionalità di collaborazione tra modelli per poter creare sistemi sempre più complessi.

Infine, è stato anche inserito un sistema di verifica automatica per l’accuratezza delle risposte. Purtroppo non si può usare sempre, perché dipende molto dal caso d’uso, ma può essere visto come un primo interessante passo per combattere le allucinazioni dell’AI.

SageMaker

SageMaker è un sistema già esistente usato per creare, addestrare e mettere in esercizio modelli di Intelligenza Artificiale. Nell’ultimo anno, SageMaker si è ampliato e ora fornisce due livelli di approcciabilità. Da una parte c’è la visione classica, come strumento di sviluppo e distribuzione dell’AI; dall’altra, troviamo una piattaforma unificata per data analytics. Pertanto, l’attività di un data scientist converge su un unico strumento, dove può gestire sia i modelli che addestra sia i dati a sua disposizione.

SageMaker, nella sua versione più recente, mette a disposizione anche strumenti di esplorazione e manipolazione dei dati. In questo contesto, gli annunci più significativi del 2024 sono stati probabilmente il lancio di SageMaker Unified Studio e Amazon SageMaker Lakehouse. Quest’ultimo, in particolare, permette di accedere in maniera unificata a dati che si trovano su fonti diverse, come Data Lake S3 e Amazon Redshift.

Infine, per la gestione di modelli di AI grandi e complessi, con SageMaker è oggi possibile usare la tecnologia degli HyperPod. Gli HyperPod sono sostanzialmente dei container corredati di una serie di strumenti in grado di facilitare la gestione e l’addestramento di un LLM.

Amazon Q

Amazon Q è il livello di astrazione più alto dello stack software con cui AWS implementa la sua Intelligenza Artificiale. Q espone applicazioni SaaS che implementano soluzioni e prodotti.

Amazon Q supporta l’esplorazione sia di dati strutturati sia di dati non strutturati (tramite QuickSight). Dal punto di vista del business, è possibile pensare a Q come a un proxy per i dati aziendali. Infatti, sarà in grado di automatizzare flussi di lavoro complessi sulla base di una descrizione in linguaggio naturale. Ad esempio, sarà possibile fargli esaminare le e-mail nella casella di posta di un utente e intraprendere delle azioni in base al loro contenuto. Uno dei principali campi di utilizzo di Amazon Q sarà ovviamente quello della Business Intelligence.

Le novità a livello infrastrutturale

AWS, durante il 2024, ha portato innovazione anche a livello di infrastruttura per i suoi Data Center. Ovviamente, tutte migliorie che hanno come tema principale la sostenibilità e l’uso dell’energia. Sostenibilità che, purtroppo, deve essere mediata anche da AWS per via della grande richiesta di energia per il calcolo inferenziale dell’AI tipica di questo momento storico.

Infatti, come anche altre multinazionali, durante la presentazione AWS ha parlato di net zero, ma per il 2040 e non più per il 2032.

Per quanto riguarda l’hardware, ora anche il colosso AWS ha iniziato a produrre il suo silicio. Infatti, già nel 2018 era stato lanciato Graviton: un processore che, rispetto alle offerte della concorrenza nella stessa classe di utilizzo, aveva un rapporto prezzo-prestazioni migliore del 40% a fronte di un consumo energetico migliorato del 60%. Il prossimo passo sarà quello di creare una generazione di processori specializzati per l’AI. Nel farlo, AWS lancia però due famiglie separate. Trainium 2 (o Trn 2) è progettato per la fase di addestramento dei modelli e, rispetto a Graviton, offrirà il 30% di potenza in più a un prezzo più basso. Per la fase di esercizio, quella in cui i modelli forniscono risposte, invece, si userà il nuovo Inferentia.

I moduli nei nuovi Ultraserver di AWS saranno il risultato dell’aggregazione di fino a 64 processori Trn 2 per una capacità di calcolo che potrà spingersi a 83.2 petaflops.

Cosa è successo nelle sezioni più classiche

Per quanto riguarda la parte compute, l’utente ha ora la possibilità, tramite Elastic VMware Service (EVS), di effettuare una propria installazione di VMware mantenendo il controllo lo stack applicativo. In pratica, è come se il sistema di virtualizzazione diventasse un’applicazione all’interno dell’infrastruttura di AWS.

Sul fronte database si sono registrati molti sviluppi. Innanzitutto, Amazon Aurora è stato esteso in due direzioni. Da una parte, c’è stato un movimento verso l’open source, non solo come modello di sviluppo ma anche, ci è stato detto, per svincolarsi dai database della vecchia guardia e dal loro modello di pricing a volte punitivo. Dall’altra, Aurora si sta trasformando in un database distribuito che può operare su una scala estremamente ampia grazie ad Amazon DSQL (Distributed SQL). Amazon DSQL gestisce autonomamente la scalabilità all’interno della singola regione mentre per collegare regioni diverse usa un approccio serverless.

Probabilmente, però, la notizia più importante in ambito database è stata la disponibilità di Oracle Exadata attraverso l’infrastruttura di AWS. In questo modo, i clienti abituati ai prodotti Oracle on-premise potranno ritrovare lo stesso tipo di esperienza passando al cloud di AWS. Per ora, purtroppo, la disponibilità è limitata agli Stati Uniti, ma speriamo di poterlo vedere anche nel vecchio continente entro il 2025.

L’ultimo gruppo di annunci riguarda S3: il sistema di storage a oggetti che è anche uno dei servizi storici di AWS. Durante il 2024, S3 si è esteso verso i Data Lake. Ora, infatti, offre un supporto nativo per dati di natura tabulare, in modo da sollevare l’utente dal compito di dover gestire Apache Iceberg. Iceberg esiste ancora nel sistema, ma la sua gestione può essere interamente delegata a S3.

- TI PRESENTIAMO IL NUOVO ECHO SPOT: un'elegante sveglia intelligente con Alexa e un suono potente. Ideale per svegliarsi, rilassarsi e molto altro.

- SVEGLIA INTELLIGENTE PERSONALIZZABILE: guarda l’ora, il meteo, i titoli delle canzoni a colpo d’occhio, controlla i dispositivi per Casa Intelligente e molto altro. Inoltre, puoi personalizzare lo schermo selezionando lo stile e il colore dell’orologio.

- SUONO POTENTE E DINAMICO: goditi un suono ricco, con voci nitide e bassi profondi. Prova a chiedere ad Alexa di riprodurre musica, podcast e audiolibri dai tuoi servizi di streaming preferiti, come Amazon Music, Apple Music, Spotify e altri. Visualizza il titolo del brano e tocca lo schermo per controllare la riproduzione.

- INIZIA LA TUA GIORNATA IN TRANQUILLITÀ: imposta una routine con Alexa per svegliarti dolcemente con la musica e le luci soffuse. Controlla l’ora e i tuoi promemoria a colpo d’occhio o chiedi ad Alexa le previsioni del tempo.

- LA TUA CASA GESTITA IN TUTTA COMODITÀ: controlla i dispositivi per Casa Intelligente compatibili. Chiedi ad Alexa di accendere le luci o tocca lo schermo per regolare la luminosità.